Posts by pedro

Q.rad, ou comment vendre de la puissance de calcul à la demande et de la chaleur !

0La technologie Q.rad

Q.rad [kyu rad], N : Radiateur électrique dont la source chaude est constituée de processeurs de calcul. Totalement silencieux, le dispositif reçoit ses instructions de calcul via le réseau Internet domestique. La chaleur dégagée par l’exécution des calculs permet de chauffer gratuitement et efficacement les habitations et locaux professionnels.

Un système de régulation par thermostat permet d’adapter la puissance de calcul en fonction de la température souhaitée par les occupants.

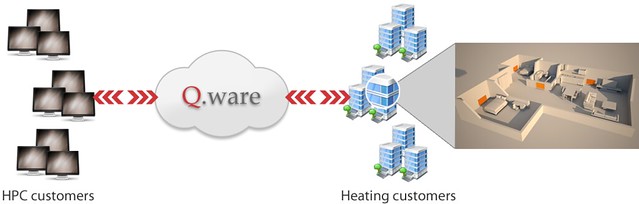

La plateforme de distribution Q.ware

Grâce à la plate-forme Q.ware, les calculs de nos clients sont distribués de manière sécurisée sur les milliers de processeurs du parc de Q.rads. Pour chaque nouveau calcul, le Q.ware analyse la charge et la distribue sur des Q.rads qui sont automatiquement bootés avec l’OS adapté dans une logique de « bare metal ».

source : Qarnot Computing

Intel cible les fournisseurs/hébergeurs de cloud avec le nouvel processeur Atom C2000

0Intel apporte sa contribution dans le cloud au travers de ses puces Atom de faible puissance. Aujourd’hui, le fondeur a annoncé la disponibilité commerciale de produits basés sur le nouveau processeur Atom C2000, une puce de faible puissance précédemment connu sous le nom de code Avoton. La nouvelle puce est conçu pour apporter l’efficacité de la puissance des téléphones mobiles dans les environnements de cloud hyperscalable.

Intel annonce que cette nouvelle puce de 22nm lui permettra également de se développer dans des domaines tels que le stockage à froid et celui des équipements réseau d’entrée de gamme.

Un autre domaine a développer selon Intel est celui de l’efficacité énergétique dont les opérateurs de datacenter sont en recherche permanente pour l’ensemble de leur infrastructure.

“Alors que le monde devient de plus en plus mobile, la pression pour soutenir des milliards de dispositifs et d’utilisateurs connectés est en train de changer la composition même des datacenters“, a déclaré Diane Bryant, vice-président senior et directeur général du groupe “Datacenter and Connected Systems” chez Intel. “Avec l’Atom C2000, nous annonçons un changement en adressant un nouveau marché de produits optimisées et qui répondent à un éventail de charges de travail bien spécifiques pour une plus grande efficacité des datacenter.”

ATOM Avoton

Plaquettes du nouveau processeur Intel Atom C2000, qui a été lancé aujourd’hui et est disponible en 13 configurations différentes pour des tâches informatiques spécialisés. (Photo: Intel)

Portugal Telecom – Le plus gros datacenter d’Europe

0C’est le 23 septembre prochain que Portugal Telecom mettra en service l’un des plus gros datacenters européens.

Europe Biggest Datacenter

Ce campus de 75 000m2 comprendra quatre bâtiments abritant au total 50 000 serveurs pour une capacité de 30 PetaOctets. Des capacités énormes pour le stockage, le Cloud, la virtualisation et de nombreux services IT.

90 millions d’euros ont été investis pour le mettre sur pied avec une empreinte environnementale aussi réduite que possible.

Portugal Telecom est d’ores et déjà persuadé que son lancement dynamisera la région de Covilhã, au centre du Portugal, aussi sur le plan économique et que celui de l’emploi. Portugal Telecom évoque la création de 400 emplois directs et de plus de 1 000 emplois indirects.

75% de l’énergie qu’il consommera proviendra de sources d’énergies renouvelables.

KPI DCEM – un nouvel indicateur d’efficacité des datacenter

0KPI DCEM – un vrai indicateur d’efficacité des datacenter

KPI DCEM pour DataCenter Energy Management, est un indicateur d’efficacité énergétique des datacenter produit par l’ETSI (European Telecommunications Standards Institute) et devient ainsi un indicateur standardisé.

Il a été produit en réponse au mandat M/462 de la Commission Européenne, au travers une spécification de groupe (GS) produite par l’ISG (Industry Specification Group) OEU (Operational energy Efficiency for Users) de l’ETSI avec le support du CTO Alliance/CRIP pour définir les outils les plus efficaces.

Il définit les indicateurs-clés de performance relatifs à la gestion énergétique dans les centres de calcul d’opérateur (ODC), les sites opérateurs (OS) et les centre de calculs des clients, et traite de quatre KPIs objectifs :

- Consommation d’énergie,

- Efficacité de traitement,

- Réutilisation d’énergie,

- Énergie renouvelable.

Un KPI global combinant ces quatre KPIs d’objectifs.

DCG définit la gabarit de consommation d’énergie du centre de calcul (Datacenter) et DCPdéfinit la performance du centre de calcul selon le gabarit associé.

Le KPI global KPIDCEM est présenté comme une combinaison de deux valeurs, DCG et DCP, sous la forme suivante:

Gabarit, Classe ; par exemple : XL, C

Ce document est disponible ici

Refroidissement de serveurs par immersion dans bain d’huile

0Mise en place d’une solution innovante de refroidissement des serveurs par immersion dans l’huile, la société texane GRC pour Green Revolution Cooling l’a fait.

Green Revolution Cooling

L’huile est un meilleur conducteur de la chaleur que l’air, elle permet ainsi d’évacuer plus facilement la chaleur et surtout permet de faire de la haute densité avec un ration au m² impossible dans un environnement traditionnel refroidit à air.

Une densité supérieur à 100 kW IT pour un simple container de 42 U de large (dimension d’une baie serveur couché), imaginez un datacenter silencieux !

L’huile utilisée est non toxique, sans odeur et ne dégrade pas les composants électroniques selon la société GRC Green Revolution Cooling.

Le seul prérequis pour pouvoir immergé un serveur est, de retirer préalablement les ventilateurs, de mettre les disques à l’extérieur ou de les protéger avec un boitier étanche et de remplacer la patte thermique entre le processeur et le radiateur par une feuille spéciale.

Site du constructeur : GRC Green Revolution Cooling

eBay propose une méthode pour mesurer l’efficacité énergétique des datacenters

0Dans le domaine des datacenters, on entend couramment dire qu’on ne peut pas gérer ce que l’on ne peut pas mesurer. Désormais, grâce au système de mesure mis au point par eBay, il va être possible de calculer l’efficacité des centres de calcul.

La méthode inventée par eBay pour mesurer l’efficacité énergétique des datacenters permet d’évaluer le coût des opérations IT en dollars, en kilowatts-heures et en équivalents carbone, et de réunir ces résultats dans une présentation métrique unique. En ce qui concerne eBay, la méthode va lui permettre de mesurer la performance des transactions d’achat et de ventes réalisées par ses clients sur eBay.com.

Le tableau de bord développé par eBay pour mesurer l’efficacité de ses serveurs

« Les résultats sont traduits en un équivalent « litres consommés par kilomètre » pour les centres de calcul, qui peut servir de repère aux entreprises pour suivre l’évolution de leur consommation énergétique », a déclaré Dean Nelson, responsable de Global Foundation Services chez eBay, un service qui gère les datacenters du site d’e-commerce dans le monde. « eBay fonctionne comme une entité unique, mais le système regroupe des millions de composantes, et nous avions besoin d’un moyen pour mesurer et connaître l’efficacité de ce système », a-t-il déclaré mardi lors du Green Grid Forum, une conférence consacrée à l’efficacité énergétique des datacenters qui s’est tenue à Santa Clara, Californie.

En rendant sa méthode publique, eBay espère que d’autres entreprises l’adopteront aussi, de la même manière que l’industrie a adopté le Power Usage Effectiveness, ou PUE, comme indicateur global de l’efficacité énergétique des centres de calcul. Le système de mesure mis au point par eBay se présente sous forme de tableau de bord. Nommé Digital Service Efficiency (DSE), cet indice va plus loin que le PUE selon eBay, puisque les mesures portent sur l’infrastructure informatique et qu’elles sont reliées avec quatre paramètres très importants pour les responsables IT : les recettes, la performance, l’impact environnemental et le coût.

52 075 serveurs physiques chez eBay

Pour convaincre du bien fondé de sa méthode, eBay a livré de nombreuses informations sur ses propres datacenters, ce qui est assez inhabituel. On apprend ainsi que, à la fin de l’année dernière, eBay faisait tourner 52 075 serveurs physiques, générant 740 tonnes de carbone par million d’utilisateurs, soit 1,6 tonne par serveur. « Cette année, eBay s’est fixé comme objectif de réduire de 10 % son coût par transaction et ses émissions de carbone par transaction, et d’augmenter le nombre de transactions par kilowatt-heure d’autant », a déclaré Dean Nelson. Par contre, les coûts en dollars, considérés comme des données sensibles vis-à-vis de la concurrence, n’ont pas été divulgués. « L’idée n’est pas de permettre à tous de connaître nos bénéfices et nos pertes, mais d’élaborer un indicateur capable de montrer les progrès que nous réalisons chaque année en matière d’efficacité énergétique », a déclaré Rohini Jain, responsable financier de l’infrastructure technologique d’eBay.

Comparativement, le géant de l’Internet a livré plus de données que ne le font la plupart des autres entreprises. Par exemple, quand il communique sur l’efficacité énergétique de ses installations, Google ne divulgue jamais le nombre de serveurs qu’il exploite, ni quelle quantité d’énergie consomment ses datacenters. Mais les autres entreprises auront peut-être du mal à reproduire la méthode d’eBay. En effet, pour évaluer sa performance, la mesure que doit effectuer eBay est assez simple : compter le nombre de transactions réalisées par ses clients, c’est-à-dire décompter les URL. Or la plupart des entreprises ont des business modèles plus complexes. Par ailleurs, eBay a aussi la particularité d’être une entreprise orientée sur la technologie, elle a tout intérêt à investir dans des projets d’économie d’énergie.

Un parc solaire pour alimenter ses datacenters

Au mois de décembre dernier, le géant de la vente aux enchères sur Internet a mis en route son premier parc solaire, d’une puissance de 650 kilowatts, et il prévoit d’installer des piles à combustible Bloom plus tard cette année lesquelles fourniront jusqu’à 6 mégawatts d’électricité. « Chez eBay, toutes les équipes – software, hardware, opérationnelles et financières – sont concernées par le projet », a ajouté le responsable de Global Foundation Services. Par exemple, les développeurs de logiciels se sont employés à ajuster la quantité de mémoire utilisée par un pool de serveurs. Ils ont permis d’éliminer 400 machines et d’économiser un mégawatt », a-t-il déclaré.

Dean Nelson a aussi rappelé que, lors de son introduction il y a 6 ans par le Green Grid Forum, le PUE avait été mal accueilli. « Mais depuis, l’indice de mesure a été largement adopté ». Comme le PUE, le DES, qui fournit une mesure en « litre consommé par kilomètre », n’est pas forcément utile en soi, mais il pourrait donner aux entreprises un point de repère pour évaluer leurs progrès. « L’an dernier, eBay a comptabilisé 46 000 transactions par kilowattheure. Est-ce une bonne performance ? Nous ne le savons pas, car nous n’avons aucune référence pour le savoir », a déclaré Dean Nelson. Cette année, eBay – et d’autres – pourra le vérifier.

Source Le mode du Cloud

SPEC SERT nouveaux KPIs de performance

0Le SPEC propose un test de performance énergétique des serveurs.

L’organisme spécialisé dans les tests de performances SPEC (Standard Performance Evaluation Corporation) a rendu public sont Server Efficiency Rating Tool qui vise à évaluer l’efficacité énergétique des serveurs dans diverses conditions de charge. Ce test contribuera à la délivrance des qualifications Energy Star de l’EPA.

Conçu pour être simple à configurer et à utiliser grâce à une interface utilisateur graphique complète, le SERT utilise un ensemble de worklets synthétiques pour tester les composants des systèmes, tels que les processeurs, la mémoire et le stockage, en fournissant des données détaillées sur la consommation d’énergie à des niveaux de charge différents.

Les résultats sont fournis sous deux formes, langage machine et langage lisible par l’humain.

Bientôt des données sur la performance énergétique des processeurs, des mémoires et du stockage.

Trois idées pour reconquérir notre souveraineté numérique

0Seules des propositions radicales empêcheront l’économie de l’Internet de prospérer au détriment des Etats et des personnes.

L’instauration d’une « dataxe » prélevée sur les collecteurs de données extraeuropéens en est une.

La souris, qu’est-ce que c’est ? »Depuis l’interrogation de Jacques Chirac devant un ordinateur en 1996, on peine à se souvenir d’une marque d’intérêt prononcé de l’exécutif pour l’économie de l’Internet en France. De ce point de vue, le séminaire gouvernemental sur le numérique jeudi dernier à Gennevilliers vient marquer une vraie rupture. Il était temps : deux études et un rapport récents rappellent à quel point la révolution numérique en cours est devenue la première force de transformation de l’économie et de la société françaises. En 2011, une étude de McKinsey chiffrait à 20% la part de la croissance économique réalisée par Internet dans les pays développés (à 25% pour la France). Ces quinze dernières années, Internet aurait détruit 500.000 emplois en France, pour en créer 1,2 million.

Qui dit mieux, en termes de chiffres ? Le BCG, qui a publié en novembre 2012 une étude sur la valeur de nos données personnelles numériques, estime que, pour la seule Union européenne, l’exploitation de ces données – celles que vous confiez, « volens nolens », à Facebook, Google, Amazon et autres capteurs d’informations lorsque vous surfez sur Internet -générera une valeur de 1.000 milliards d’euros. L’équivalent du prochain budget de l’Union européenne sur sept ans.

Formidable, mais pour qui donc ? Pour vous ? Non. Pour les gouvernements ? Encore moins. Il suffit de se rapporter à la très décalée devise de Google (« don’t be evil ») et aux impôts sur bénéfices que paye cette société en Europe (à peu près nuls : les bénéfices remontent dans le paradis fiscal irlandais, et repassent par le paradis fiscal néerlandais, avant de disparaître dans les Bermudes), pour comprendre que les entreprises prospérant sur l’utilisation de vos données personnelles ne souhaitent aucunement partager ce gâteau à 1.000 milliards d’euros.

Dans ce contexte, le rapport gouvernemental Collin et Colin, récemment publié, vient dresser un constat éclairant : les acteurs de l’économie Internet, celle qui va faire notre croissance économique, se sont organisés pour s’affranchir complètement des États et des individus. S’est installée une forme tacite d’expropriation des données et richesses individuelles, qu’il convient de corriger. Leurs analyses montrent comment, en ignorant ce phénomène de marchandisation des données, au nom de principes vertueux (nos données ne sauraient être des marchandises), nous avons laissé s’échapper une valeur considérable. Leurs propositions pour « reterritorialiser » les données, et tenter de fiscaliser des établissements fictifs (« taxer les fantômes » : pas de siège, pas d’usine, pas d’employés pour le moteur de recherche Google), sont un premier pas dans la bonne direction.

Mais, si l’on veut aller vite et ne pas laisser l’économie de l’Internet prospérer au détriment des États et des personnes, il faut une proposition plus radicale. Elle existe, et s’inscrit dans la tradition pionnière de la France, dans le registre du droit d’auteur imaginé par Beaumarchais en 1777. Cette idée radicale se trouve dans une contribution de Pierre Bellanger, PDG de Skyrock, au rapport Collin & Colin (« la liberté compétitive »). Elle est très simple :

Les données personnelles sont la propriété des personnes ; or, « la propriété étant un droit inviolable et sacré, nul ne peut en être privé » (article 17 de la déclaration des droits de l’homme de 1789).

Les collecteurs de données personnelles (les « serveurs ») doivent être fixés au territoire où s’effectue la collecte – le pillage à distance, c’est fini : si Facebook, Amazon, Google etc. veulent collecter les données personnelles de 500 millions d’Européens, les serveurs seront installés en Europe, sous droit et contrôle européens.

Si un collecteur de données personnelles européennes veut les transférer hors d’Europe, il en a le droit. Mais il lui faudra payer une taxe (« dataxe »). Toute entreprise contrevenant à ce dispositif ne pourra plus avoir accès au marché européen. En attendant l’établissement d’une telle dataxe, pour laquelle les unités de mesure existent déjà (autour des « datagrammes » de Louis Pouzin, polytechnicien français à l’origine de découvertes ayant permis la naissance d’Internet), rappelons qu’elle pourrait connaître le même sort que la TVA, cette autre invention française incongrue (en 1954) qui finit par être copiée dans le monde entier.

Il n’est pas nécessaire d’attendre l’éveil de la Commission européenne sur ces sujets pour lancer cette initiative : la reconquête de la souveraineté numérique de nos États doit être une priorité pour la France et l’Union européenne. Il ne s’agit pas de stigmatiser tel ou tel acteur nord-américain, mais bien d’édicter une règle commune à tous, qui nous permettra de pleinement tirer profit de la révolution numérique en cours. Une révolution pour laquelle la France dispose d’atouts majeurs dans les domaines qui feront la croissance et les emplois de demain : processus manufacturiers par impression en 3D, e-learning, intelligence artificielle, et autres activités stratégiques qui feront l’objet de chroniques prochaines…

Source : Chronique d’ Edouard Tétreau, du journal Les Echos

Google économise un milliard de dollars grâce au Green IT

0Le 09 octobre dernier, Google a convié une poignée d’institutions à une réunion sur le thème de « la contribution du numérique à la transition énergétique ». L’Alliance Green IT et GreenIT.fr y étaient conviés. Nous sommes une dizaine de personnes, représentants principalement d’associations professionnelles, politiques ou gouvernementales.

Sous prétexte de « transition énergétique » à la mode, l’objectif de la réunion est de présenter les actions que mène Google en matière de consommation énergétique et de réduction de son empreinte carbone. La présentation est plutôt réussie même si elle ne révèle pas vraiment de scoop, tout ce qui est présenté est déjà disponible sur www.google.com/green.

D’une façon générale, si toutes les entreprises avaient la même politique environnementale que Google, tous les consultants en Green IT seraient millionnaires car les initiatives sont nombreuses et variées… Parmi toutes les mesures qui nous sont présentées, on notera :

- Le fameux datacenter finlandais avec un PUE qui flirte les 1,2 et qui est refroidi à l’eau de mer.

- L’utilisation massive (un tiers de leur consommation) d’électricité d’origine renouvelable soit par l’achat de certificats verts, soit par l’implantation directe de parc éolien.

- La compensation carbone. Selon Google, leur consommation électrique en 2011 s’est élevée à 2 675 898 MWh, soit 1,3% de la consommation mondiale des Datacenters.

Certes il est plus facile pour Google d’être « vert » car ils partent d’une feuille blanche. Pour une entreprise qui a des dizaines d’années d’histoire avec son système d’information, la démarche est un peu plus complexe. Il n’en reste pas moins que de nombreuses idées ont été mises en pratiques et que, selon Google, faire du Green IT n’a pas contribué à augmenter les dépenses, bien au contraire. L’ensemble des mesures mises en œuvre aurait permis de baisser la facture électrique de l’ordre d’un milliard de dollars. Et, visiblement, c’est bon pour leur image.

Source : GreenIT.fr